Автор: Александр Казанцев, руководитель направления по работе с документацией и контентом HOSTKEY

Профессиональную видеокарту RTX PRO 2000 Blackwell сама NVIDIA позиционирует как компактное и энергоэффективное решение для профессиональных рабочих станций, ускоряющее графику и ИИ-задачи. Обещается максимальная AI-производительность с FP4, DLSS 4 и оптимизацией для RTX Neural Shaders, Mega Geometry, а также поддержка сложных multi-app workflow: генеративный ИИ, 8K-видео, реал-тайм рендеринг, CAD с ray tracing. То есть карта создана для применения в создании контента, 3D-дизайне, видео- и CAD-воркфлоу.

У нас в HOSTKEY эта карта рассматривается как замена в серверах не поддерживаемых уже драйверами 1080Ti и как альтернатива 16Гб A4000. Но что мы реально получаем за 85000 рублей?

Странные спеки

Начнем со спецификации. Так как это карта семейства Blackwell, то сравнить ее можно по характеристикам с той же RTX 6000 PRO Blackwell.

|

Характеристика |

NVIDIA RTX PRO 6000 Blackwell |

NVIDIA RTX PRO 2000 Blackwell |

|---|---|---|

|

Архитектура |

Blackwell |

Blackwell |

|

CUDA-ядра |

24 064 |

4352 |

|

Tensor Cores |

752 (5-го поколения) |

136 (5-го поколения) |

|

RT Cores |

188 (4-го поколения) |

34 (4-го поколения) |

|

Память |

96 ГБ GDDR7 ECC |

16 ГБ GDDR7 ECC |

|

Пропускная способность |

1597–1792 ГБ/с |

288 ГБ/с |

|

TDP |

600 Вт |

70 Вт |

|

Интерфейс |

PCIe 5.0 x16 |

PCIe 5.0 x8 |

|

AI TOPS |

До 4000 |

545 |

|

Форм-фактор |

FHFL, dual-slot, пассивное охлаждение |

Компактный SFF |

Как видно, урезание произошло даже не в три раза, и по факту мы получили карту, урезанную до пятой части от старшей серверной модели.

А как эта карта выглядит в сравнении с потребительским сегментом? Учитывая ее характеристики, можно было бы предположить, что она будет примерно совпадать с 5060 Ti на 16 Гб. Но результат и тут немного обескуражил:

RTX PRO 2000 Blackwell, RTX 5060 Ti 16 ГБ и RTX 5060 — всё это GPU на архитектуре Blackwell начального уровня. Все используют PCIe 5.0 x8 и память GDDR7.

Сравнение спецификаций

|

Характеристика |

RTX PRO 2000 Blackwell |

RTX 5060 Ti 16 ГБ |

RTX 5060 8 ГБ |

|---|---|---|---|

|

CUDA-ядра |

4352 |

4608 |

3840 |

|

Tensor Cores |

136 (5-го поколения) |

144 (5-го поколения) |

120 (5-го поколения) |

|

RT Cores |

34 (4-го поколения) |

36 (4-го поколения) |

30 (4-го поколения) |

|

Память |

16 ГБ GDDR7 ECC |

16 ГБ GDDR7 |

8 ГБ GDDR7 |

|

Пропускная способность |

288 ГБ/с |

448 ГБ/с |

448 ГБ/с |

|

TDP |

70 Вт |

180 Вт |

145 Вт |

|

AI TOPS |

545 |

759 |

~500 |

|

FP32 производительность |

16.97 TFLOPS |

23.7 TFLOPS |

19.2 TFLOPS |

|

Форм-фактор |

Компактный SFF |

2.5-слотовый |

2-2.5 слотовый |

По характеристикам ядер наша RTX PRO 2000 лежит между RTX 5060 Ti и RTX 5060, по AI превосходит 5060 (хотя и ненамного), как и по характеристикам, но проигрывает по производительности FP32. Хотя, возможно, тут играет роль «задушенное» питание карты, так как ее энергопотребление меньше в два раза даже 5060, и меньшая пропускная способность (хотя память тут та же GDDR7 с ECC, и шина PCI-E урезана так же, как у 5060).

И последнее сравнение с A4000. Начнем с цены: сейчас A4000 можно найти в районе 130 000 рублей. То есть RTX PRO 2000 Blackwell обойдется на 35% дешевле, чем A4000. Но что там по спекам?

|

Характеристика |

NVIDIA RTX A4000 |

NVIDIA RTX PRO 2000 Blackwell |

|---|---|---|

|

Архитектура |

Ampere |

Blackwell |

|

CUDA-ядра |

6144 |

4352 |

|

Tensor Cores |

192 (3-го поколения) |

136 (5-го поколения) |

|

RT Cores |

48 (2-го поколения) |

34 (4-го поколения) |

|

Память |

16 ГБ GDDR6 ECC |

16 ГБ GDDR7 ECC |

|

Пропускная способность |

448 ГБ/с |

288 ГБ/с |

|

TDP |

140 Вт |

70 Вт |

|

Интерфейс |

PCIe 4.0 x16 |

PCIe 5.0 x8 |

|

AI TOPS |

Не указано |

545 |

|

Форм-фактор |

Single-slot |

Компактный, SFF |

Как видно, A4000 обладает лучшей пропускной способностью памяти, но предыдущей архитектуры, и большим числом всех ядер (хоть и предыдущего поколения Ampere), но при этом потребляет в два раза больше энергии, чем RTX PRO 2000 Blackwell. Также она обменивается данными по 16 линиям PCI-E, но Gen4, а не Gen5.

Надо тестировать

Проверять карту будем в сравнении с A4000 в рекомендованных самой NVIDIA применениях: инференсе LLM, генерации изображений и видео, а также проверим работу карты в рендере Blender.

Для тестирования инференса будет использовать наш тест скрипт на основе Ollama.

Конфигурация сервера у нас такая: AMD Ryzen 9 5900X 3.7ГГц (12 ядер)/64Гб/1Тб NVMe SSD/PSU+RTX PRO 2000.

Хотя наша подопытная имеет компактный короткий PCB, но референсный дизайн всё равно делает её двухслотовой картой длиной около 6,6 дюйма с турбинным охлаждением.

«Странный» черный кожух на фото, увеличивающий размеры нашей малютки, позволяет забирать воздух изнутри корпуса и выдувать его наружу, чтобы горячий воздух не скапливался вокруг процессора и памяти.

За A4000 будет отдуваться похожая конфигурация, только процессор был Ryzen 5950X 16x3.4 ГГц, но он у нас в тестировании не участвует и на сравнение не влияет.

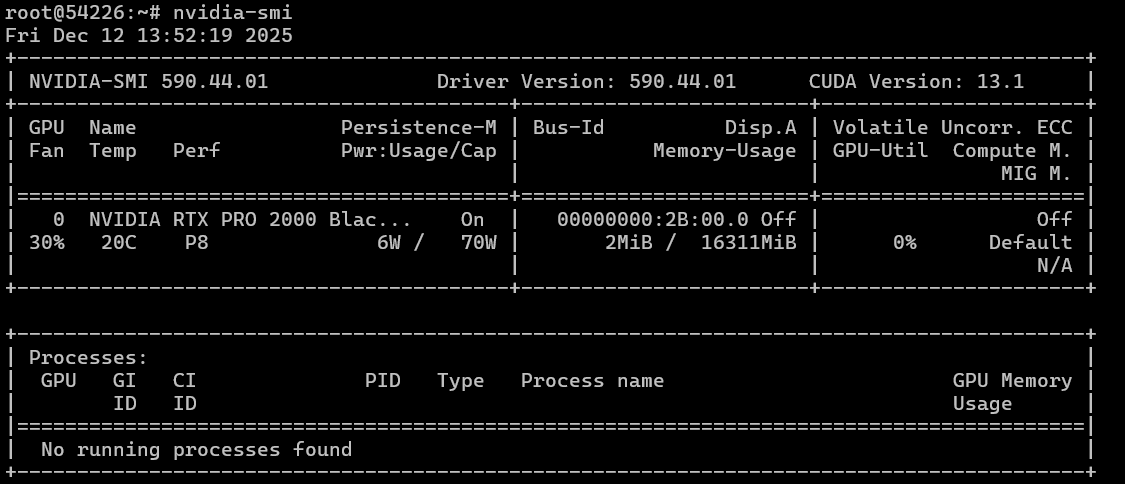

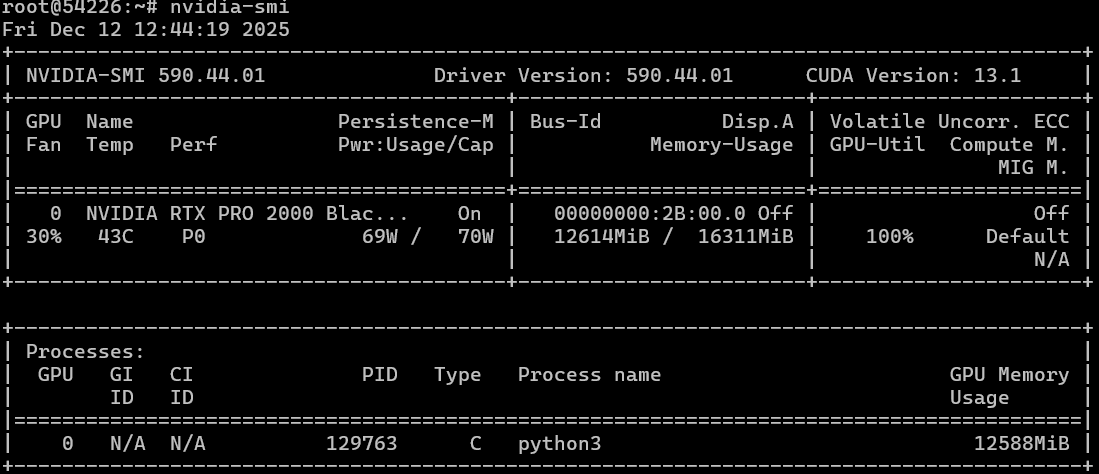

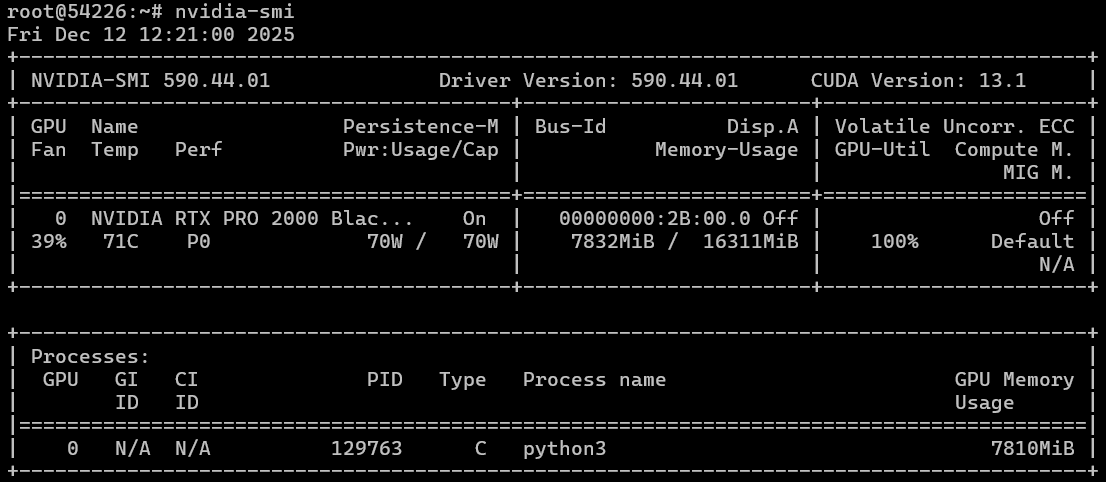

Ставим на обе машины Ubuntu 22.04 и с помощью нашего скрипта накатываем драйвера и CUDA. В итоге имеем для RTX PRO 2000 Blackwell в простое следующие значения:

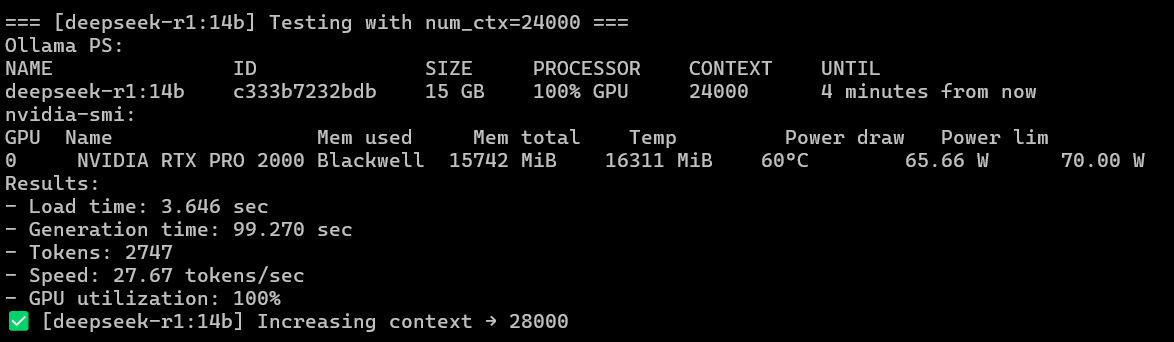

Как видно, без нагрузки карта банально «комнатной температуры». Тестирование будем проводить на нескольких моделях, включая «старичка» DeepSeek-R1:14B, чуть более свежий gpt-oss:20B с MOE и новенький мультимодальный mixstral3:14B (и заодно более быстрый 8B) с распознаванием картинок. Все модели с квантизацией Q4.

Итоговый результат сведем в таблицу, где для сравнения приведем для deepseek цифры у RTX 6000 PRO Blackwell.

|

GPU |

Модель |

Скорость генерации (токенов в секунду) |

max ctx |

Скорость загрузки модели (секунд) |

Скорость генерации (секунд) |

Примечание |

|---|---|---|---|---|---|---|

|

NVIDIA RTX 6000 PRO Blackwell (gen5) |

deepseek-r1:14b |

114.02 |

128 000 |

1.74 |

22.71 |

|

|

NVIDIA RTX A4000 (gen4) |

deepseek-r1:14b |

35.81 |

24 000 |

11.72 |

74.37 |

|

|

NVIDIA RTX PRO 2000 Blackwell |

deepseek-r1:14b |

27.79 |

24 000 |

3.68 |

91.91 |

|

|

NVIDIA RTX A4000 (gen4) |

ministral-3:8b |

65.42 |

64 000 |

12.92 |

44.98 |

Visual |

|

NVIDIA RTX PRO 2000 Blackwell |

ministral-3:8b |

48.21 |

68 000 |

3.17 |

63.97 |

Visual |

|

NVIDIA RTX A4000 (gen4) |

ministral-3:14b |

42.28 |

36 000 |

13.99 |

86.12 |

Visual |

|

NVIDIA RTX PRO 2000 Blackwell |

ministral-3:14b |

30.97 |

36 000 |

3.68 |

115.42 |

Visual |

|

NVIDIA RTX A4000 (gen4) |

gpt-oss:20b |

84.06 |

120 000 |

14.89 |

30.85 |

Mixture of Experts |

|

NVIDIA RTX PRO 2000 Blackwell |

gpt-oss:20b |

62.54 |

120 000 |

4.23 |

43.26 |

Mixture of Experts |

Краткий итог: RTX PRO 2000 Blackwell медленнее в инференсе, чем A4000. Единственный параметр, по которому она выигрывает, это время старта, то есть время первичной загрузки в память. Цифры скорости по моделям следующие (проценты, на сколько A4000 медленнее RTX PRO 2000 Blackwell при инференсе токенов в секунду):

- Deepseek-r1:14b ~ 28%

- ministral-3:8b ~ 27%

- Ministral-3:14b ~ 27%

- gpt-oss:20b ~ 26%

Как видно, в среднем цифра примерно одинакова для классических моделей, так и для MoE. Несмотря на особенности архитектуры Mixture of Experts (MoE), где активируется лишь малая доля параметров, что лучше использует сильные стороны Ampere-архитектуры A4000 с её высокой пропускной способностью памяти (384 ГБ/с GDDR6 на 16 ГБ) и большим кэшем L2, наш «огрызок» прекрасно справляется при меньших мощностях благодаря новому Tensor Core.

При этом A4000 раскочегаривается под нагрузкой до 83°C и потребляет более 130 Вт из 140 возможных. RTX PRO 2000 Blackwell при этом держит 59°C при потреблении 65 Вт из 70 возможных.

Генерация изображений и видео

Здесь мы воспользуемся ComfyUI, в котором протестируем генерацию картинок через Z-image Turbo и видео в режиме текст-в-видео и изображение-в-видео в модели Kandinsky 5 Lite. Поставить ComfyUI на сервер можно так (для тестов мы ставим всё от root и без использования виртуального окружения):

#!/usr/bin/env bash

set -euo pipefail

COMFY_DIR="/root/comfy/ComfyUI"

LISTEN_IP="${LISTEN_IP:-0.0.0.0}"

export DEBIAN_FRONTEND=noninteractive

apt-get update -y

apt-get install -y git python3 python3-pip ca-certificates

# install/update ComfyUI

if [[ -d "${COMFY_DIR}/.git" ]]; then

git -C "$COMFY_DIR" pull --ff-only

else

mkdir -p "$(dirname "$COMFY_DIR")"

git clone https://github.com/comfyanonymous/ComfyUI.git "$COMFY_DIR"

fi

# python deps (system-wide, since venv is not wanted)

cd "$COMFY_DIR"

python3 -m pip install --upgrade pip wheel

python3 -m pip install -r requirements.txt

# run

exec python3 main.py --listen "${LISTEN_IP}"Для быстрой установки модели Z-image Turbo на сервере (после установки ComfyUI) вы можете применить такой скрипт:

#!/usr/bin/env bash

set -euo pipefail

COMFY_DIR="/root/comfy/ComfyUI"

MODELS_DIR="${COMFY_DIR}/models"

# URL -> relative path inside ComfyUI/models/

declare -A FILES=(

["https://huggingface.co/Comfy-Org/z_image_turbo/resolve/main/split_files/text_encoders/qwen_3_4b.safetensors"]="text_encoders/qwen_3_4b.safetensors"

["https://huggingface.co/Comfy-Org/z_image_turbo/resolve/main/split_files/vae/ae.safetensors"]="vae/ae.safetensors"

["https://huggingface.co/Comfy-Org/z_image_turbo/resolve/main/split_files/diffusion_models/z_image_turbo_bf16.safetensors"]="diffusion_models/z_image_turbo_bf16.safetensors"

["https://huggingface.co/tarn59/pixel_art_style_lora_z_image_turbo/resolve/main/pixel_art_style_z_image_turbo.safetensors"]="loras/pixel_art_style_z_image_turbo.safetensors"

)

# sanity checks

if [[ ! -d "$COMFY_DIR" ]]; then

echo "ERROR: ComfyUI dir not found: $COMFY_DIR"

exit 1

fi

mkdir -p \

"${MODELS_DIR}/text_encoders" \

"${MODELS_DIR}/vae" \

"${MODELS_DIR}/diffusion_models" \

"${MODELS_DIR}/loras"

# downloader (aria2c preferred for resume + parallel chunks)

if command -v aria2c >/dev/null 2>&1; then

DL="aria2c -c -x 8 -s 8 -k 1M --allow-overwrite=true --file-allocation=none"

else

apt-get update -y

apt-get install -y curl ca-certificates

DL="curl -L --fail --retry 5 --retry-delay 2 -C - -o"

fi

for url in "${!FILES[@]}"; do

rel="${FILES[$url]}"

out="${MODELS_DIR}/${rel}"

tmp="${out}.part"

echo "==> ${rel}"

mkdir -p "$(dirname "$out")"

if command -v aria2c >/dev/null 2>&1; then

# aria2c writes directly to target

$DL -d "$(dirname "$out")" -o "$(basename "$out")" "$url"

else

$DL "$tmp" "$url"

mv -f "$tmp" "$out"

fi

done

echo

echo "Done. Files are in:"

echo " ${MODELS_DIR}/text_encoders/"

echo " ${MODELS_DIR}/vae/"

echo " ${MODELS_DIR}/diffusion_models/"

echo " ${MODELS_DIR}/loras/"Промт для изображения следующий:

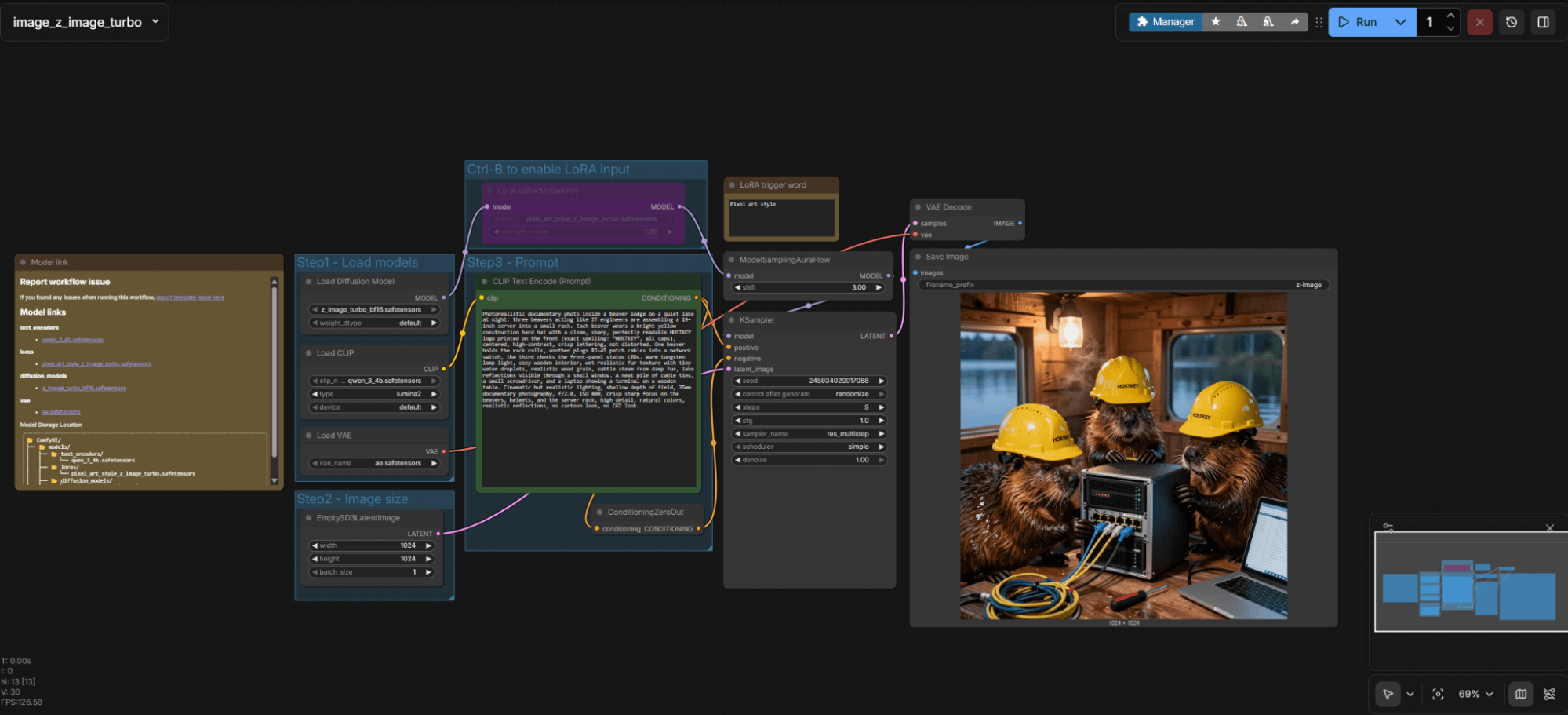

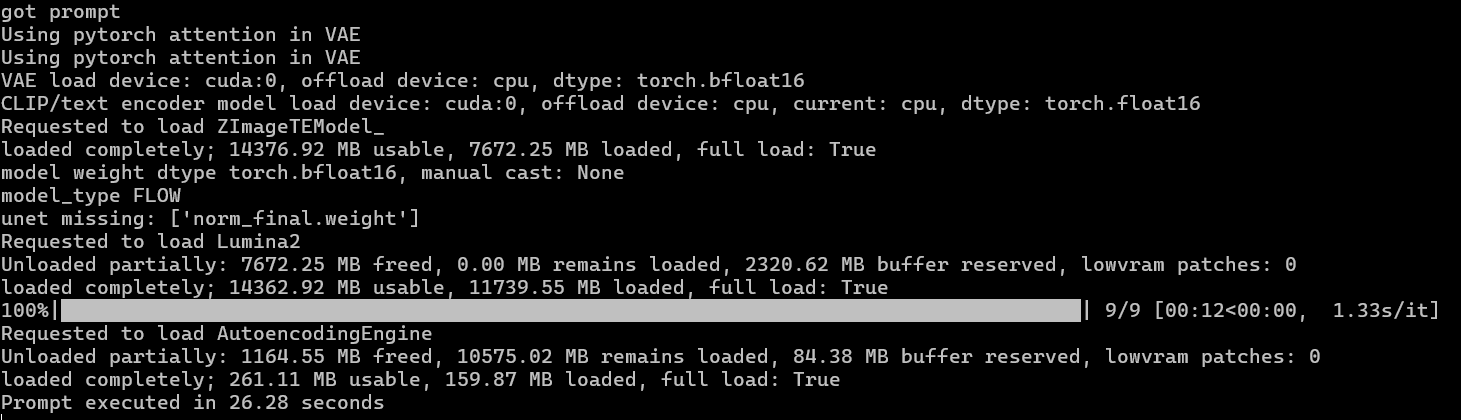

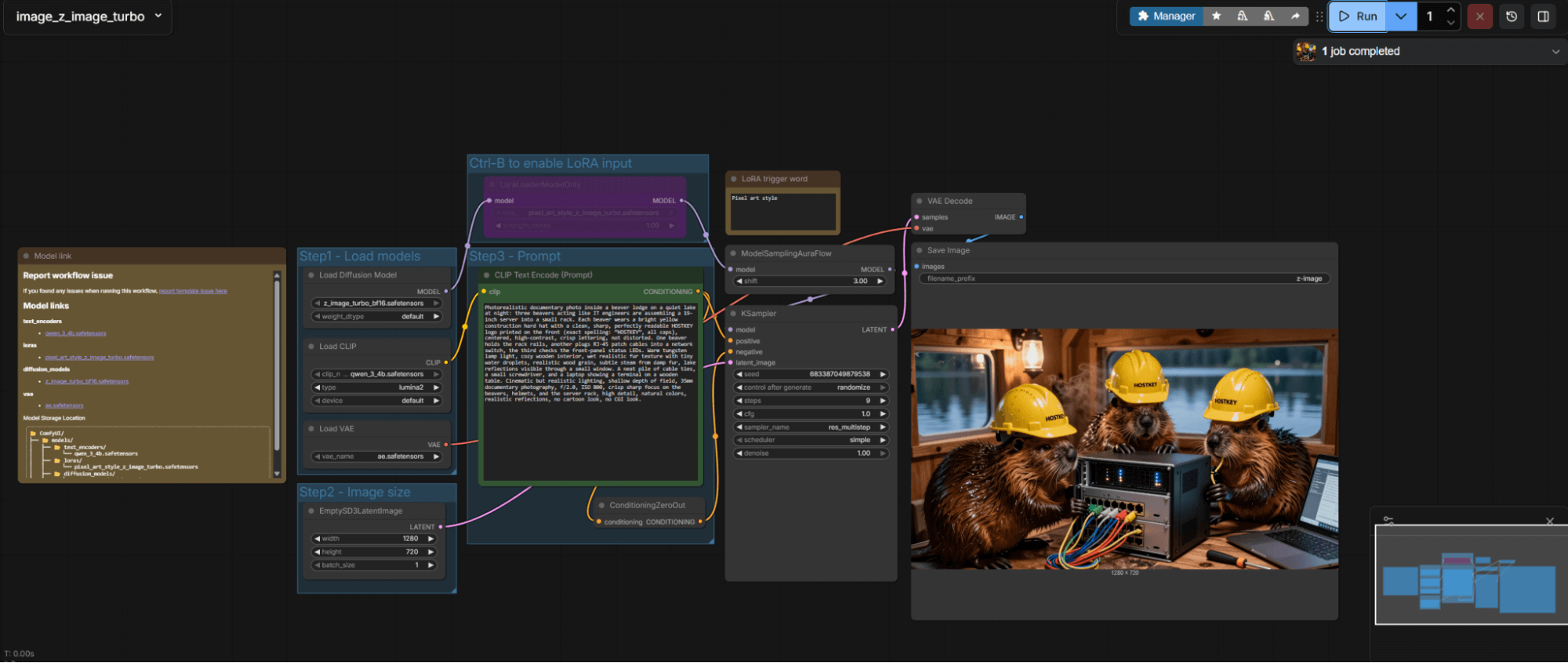

Результаты получаем следующие. Холодный прогон (он же первый) в Z-Image Turbo. Все параметры на изображении.

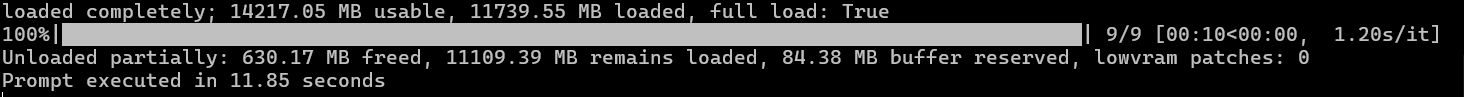

Двадцать шесть секунд секунд для картинки 1024x1024 при 9 итерациях. Последующие генерации или изменение размера будут происходить чуть быстрее. Например, изменим соотношение сторон на 1280x720.

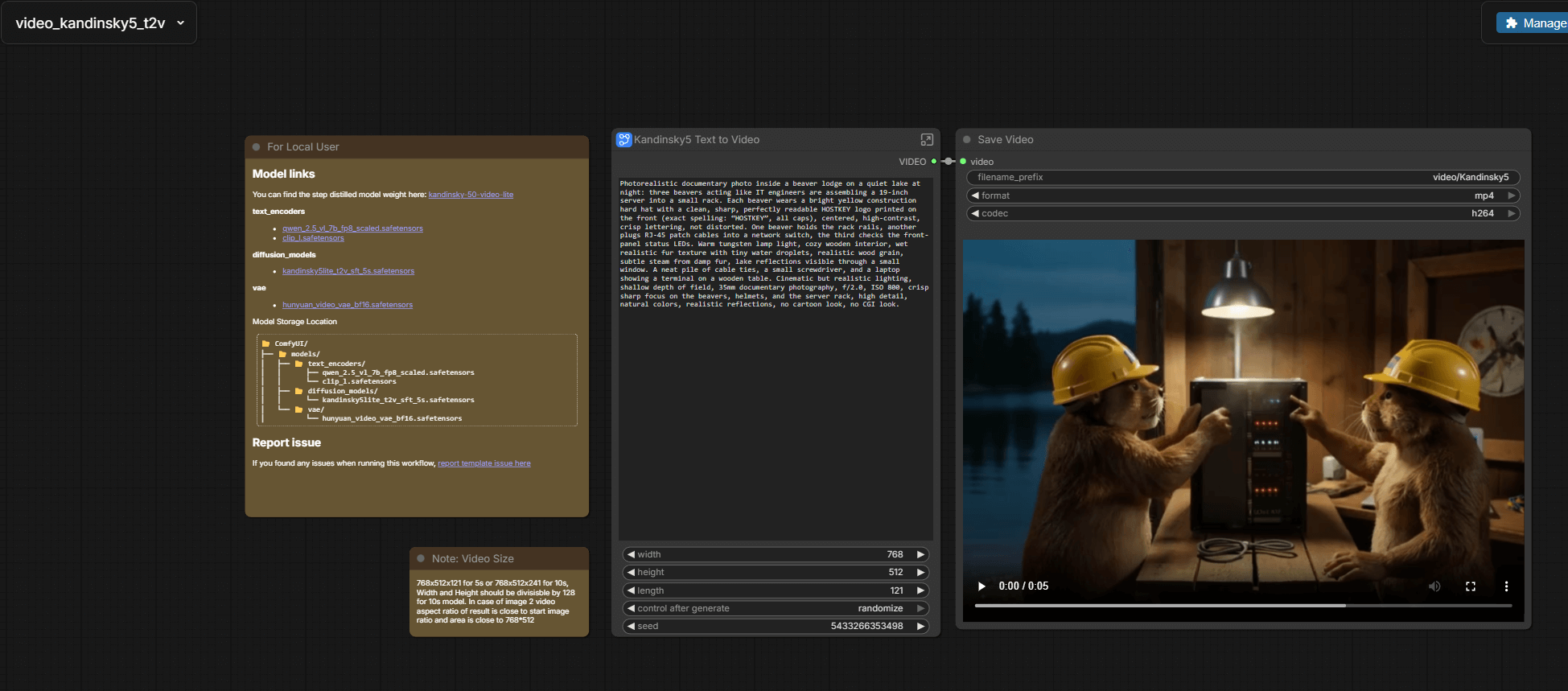

Теперь сгенерируем видео Kandinsky 5 Lite. Нам же обещали, что мощности RTX PRO 2000 Blackwell хватит и для такой задачи.

Сперва пробуем наш промт в режиме «текст в видео». Модель ставим таким скриптом:

#!/usr/bin/env bash

set -euo pipefail

COMFY_DIR="/root/comfy/ComfyUI"

MODELS_DIR="${COMFY_DIR}/models"

declare -A FILES=(

["https://huggingface.co/Comfy-Org/HunyuanVideo_1.5_repackaged/resolve/main/split_files/text_encoders/qwen_2.5_vl_7b_fp8_scaled.safetensors"]="text_encoders/qwen_2.5_vl_7b_fp8_scaled.safetensors"

["https://huggingface.co/comfyanonymous/flux_text_encoders/resolve/main/clip_l.safetensors?download=true"]="text_encoders/clip_l.safetensors"

["https://huggingface.co/Kijai/HunyuanVideo_comfy/resolve/main/hunyuan_video_vae_bf16.safetensors"]="vae/hunyuan_video_vae_bf16.safetensors"

["https://huggingface.co/kandinskylab/Kandinsky-5.0-T2V-Lite-sft-5s/resolve/main/model/kandinsky5lite_t2v_sft_5s.safetensors"]="diffusion_models/kandinsky5lite_t2v_sft_5s.safetensors"

)

if [[ ! -d "$COMFY_DIR" ]]; then

echo "ERROR: ComfyUI dir not found: $COMFY_DIR"

exit 1

fi

mkdir -p \

"${MODELS_DIR}/text_encoders" \

"${MODELS_DIR}/vae" \

"${MODELS_DIR}/diffusion_models"

# Prefer aria2c for resume/large files

if command -v aria2c >/dev/null 2>&1; then

DL_ARIA2=1

else

apt-get update -y

apt-get install -y aria2 ca-certificates

DL_ARIA2=1

fi

for url in "${!FILES[@]}"; do

rel="${FILES[$url]}"

out="${MODELS_DIR}/${rel}"

dir="$(dirname "$out")"

name="$(basename "$out")"

echo "==> ${rel}"

mkdir -p "$dir"

# -c resume, -x/-s connections, -k chunk size

aria2c -c -x 8 -s 8 -k 1M --allow-overwrite=true --file-allocation=none \

-d "$dir" -o "$name" "$url"

done

echo

echo "Done. Verify files exist:"

echo " ${MODELS_DIR}/text_encoders/qwen_2.5_vl_7b_fp8_scaled.safetensors"

echo " ${MODELS_DIR}/text_encoders/clip_l.safetensors"

echo " ${MODELS_DIR}/vae/hunyuan_video_vae_bf16.safetensors"

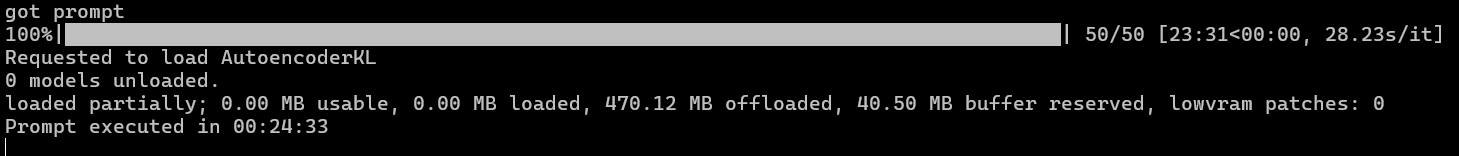

echo " ${MODELS_DIR}/diffusion_models/kandinsky5lite_t2v_sft_5s.safetensors"Здесь у нас получилось разогреть карту почти до 70 градусов и выбрать всю доступную мощность.

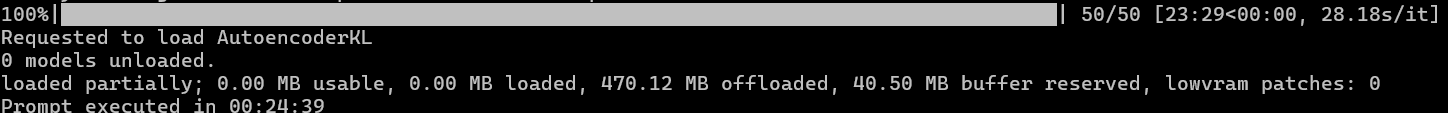

Итоговый результат:

И время в двадцать четыре с лишним минуты на 5 секунд видео в разрешении 768x512.

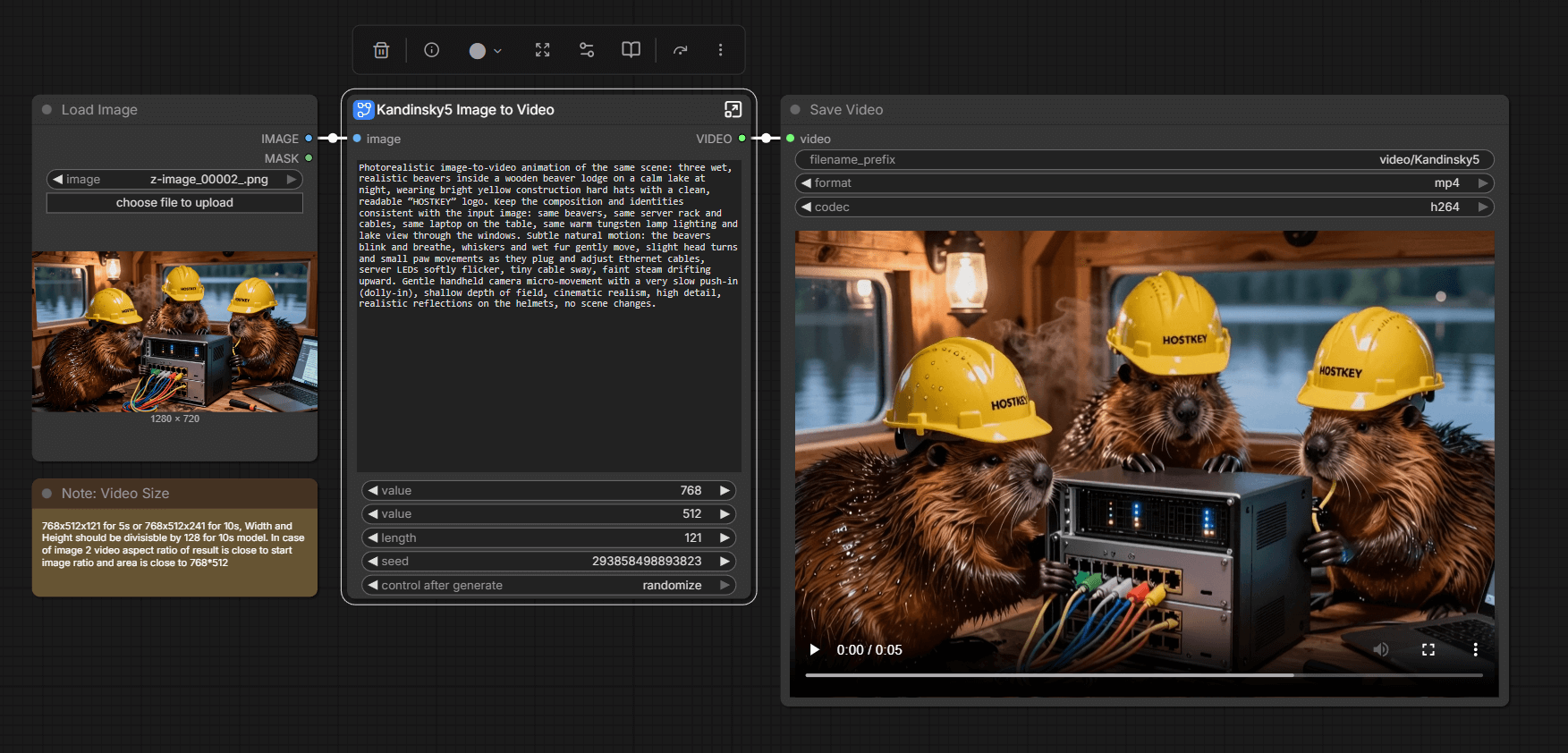

Далее возьмем картинку, которую мы сгенерировали ранее, и попробуем ее оживить. Добавляем недостающие части для работы:

#!/usr/bin/env bash

set -euo pipefail

COMFY_DIR="/root/comfy/ComfyUI"

MODELS_DIR="${COMFY_DIR}/models"

URL="https://huggingface.co/kandinskylab/Kandinsky-5.0-I2V-Lite-5s/resolve/main/model/kandinsky5lite_i2v_5s.safetensors"

OUT="${MODELS_DIR}/diffusion_models/kandinsky5lite_i2v_5s.safetensors"

mkdir -p "$(dirname "$OUT")"

# aria2c preferred (resume + faster)

if command -v aria2c >/dev/null 2>&1; then

aria2c -c -x 8 -s 8 -k 1M --allow-overwrite=true --file-allocation=none \

-d "$(dirname "$OUT")" -o "$(basename "$OUT")" "$URL"

else

apt-get update -y

apt-get install -y curl ca-certificates

curl -L --fail --retry 5 --retry-delay 2 -C - -o "$OUT" "$URL"

fi

echo "Installed: $OUT"Затем оживляем нашу картинку, используя следующий промт:

Те же двадцать четыре минуты. С одной стороны, результат не сильно впечатляет, с другой стороны, карта работает в данном режиме, хоть и не сверхбыстро. Для моделей, которые помещаются в 16 Гб памяти, карта подходит достаточно хорошо, учитывая, что на A4000 у меня рендер не запустился того же видео — не хватило каких-то архитектурных особенностей.

Рендер в Blender

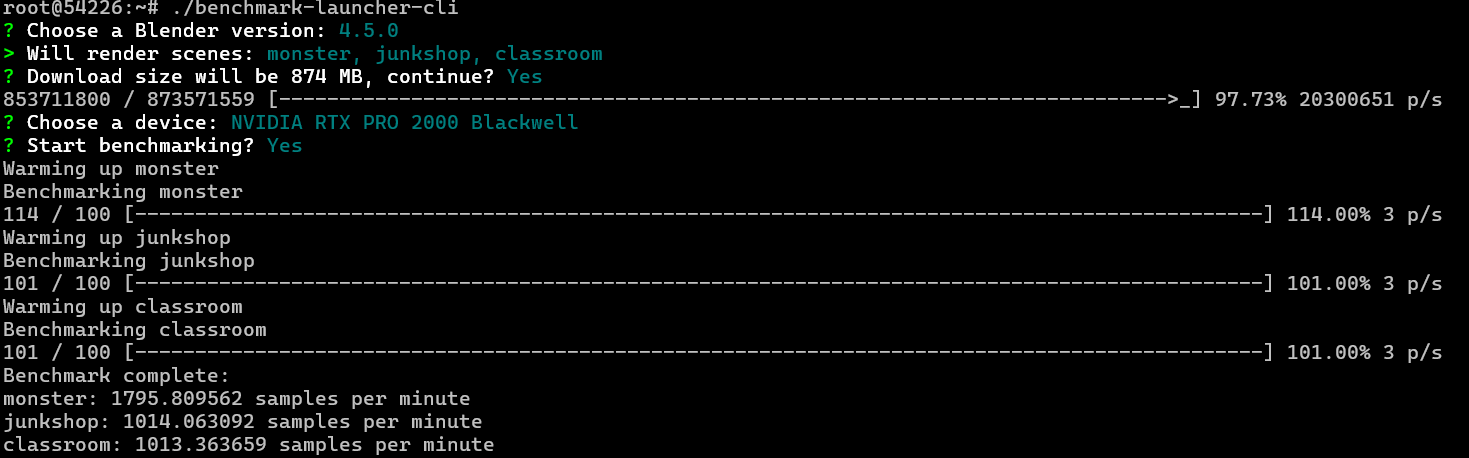

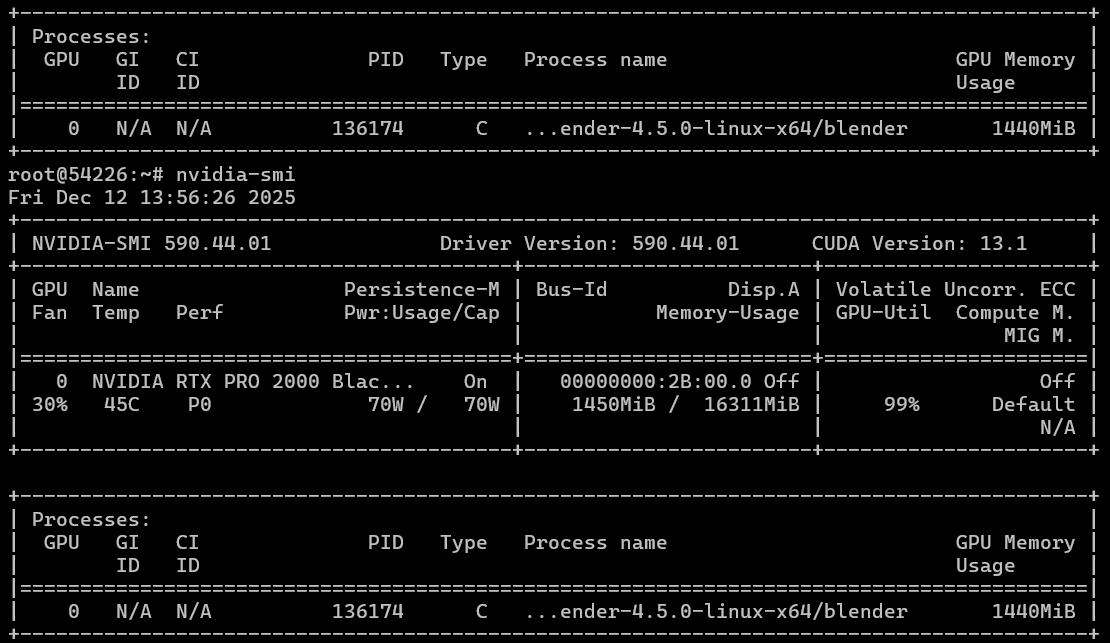

Для тестирования будем использовать скрипты с https://opendata.blender.org/. Ставим через snap последнюю версию (у нас поставилась уже новая пятерка) и качаем с сайта бенчмарк для Linux, распаковываем и запускаем его.

В бенчмарке карта также вышла на полную мощность по потреблению, но температура карты была небольшой, как и утилизация памяти.

По итогу мы получили три результата в трех сценах:

- monster: 1782.994259 samples per minute

- junkshop: 1010.288134 samples per minute

- classroom: 1008.595210 samples per minute

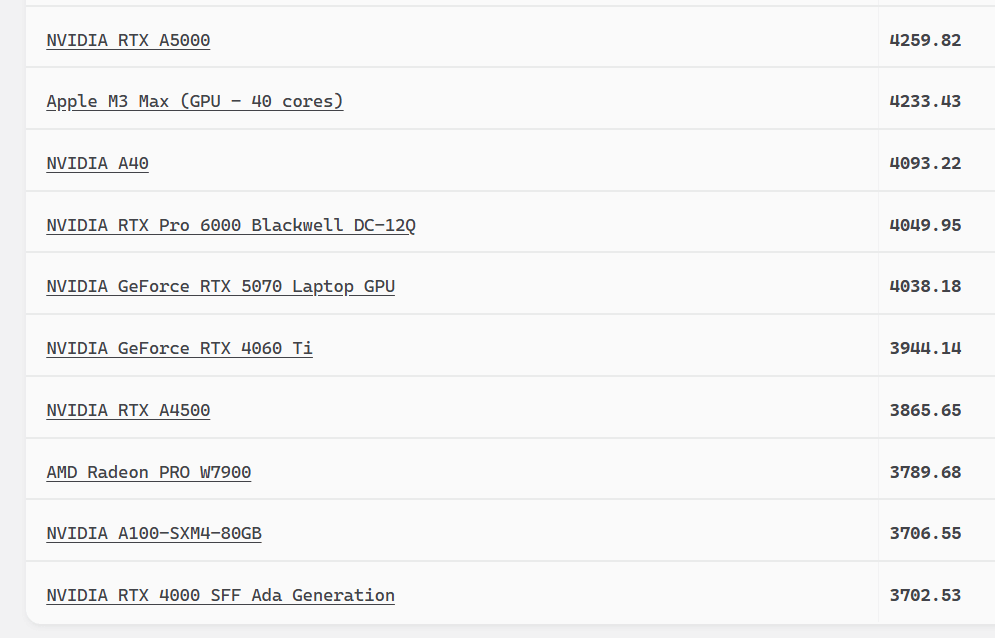

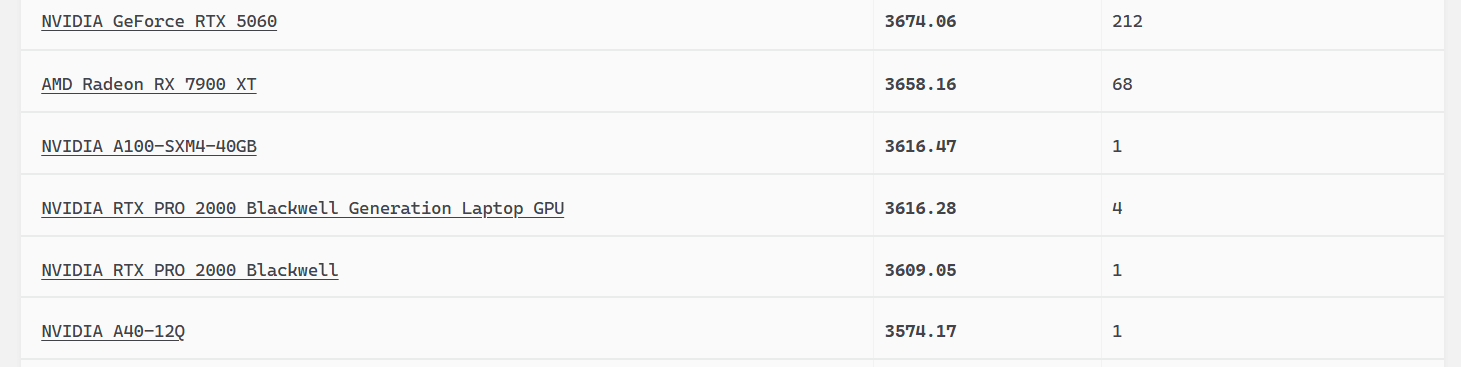

Сложив их вместе, получаем Medium score 3801.877603 сэмплов в минуту, и эту цифру уже можно сравнить с другими.

Эти цифры чуть не дотягивают до NVIDIA RTX A4500, но ниже чем у RTX 4060 Ti.

Опять же, мы тестировали на Blender 5, а здесь цифры для Blender 4.5.0, и если глянуть в таблицу, то результат других пользователей еще меньше.

То есть у нас карта отработала в тестах гораздо лучше. Возможно как раз повлиял новый Blender и оптимизация драйверов и CUDA.

Подведем итоги

Что мы имеем: холодную карту в компактном исполнении с низким энергопотреблением на новейшей архитектуре NVIDIA, которая чуть больше четверти проигрывает своей предшественнице A4000 в инференсе, но при этом стоит дешевле A4000 и потребляет в два раза меньше энергии. Поэтому ее можно рекомендовать как для применения в каких-либо нейросетевых задачах с небольшой нагрузкой и моделями размерностью до 14B/20B (в зависимости от архитектуры), особенно где требуется их часто менять: стартует с новой моделью RTX PRO 2000 Blackwell за 3-4 секунды.

Нам лично карта понравилась, установилась она достаточно беспроблемно, а потери производительности покрываются энергопотреблением, температурой и размерами.