С развитием генеративного искусственного интеллекта (ИИ) и расширением сфер его применения создание серверов с искусственным интеллектом стало критически важным для различных секторов — от автопрома до медицины, а также для образовательных и государственных учреждений.

Эта статья рассказывает о наиболее важных компонентах, которые влияют на выбор сервера для искусственного интеллекта, — о центральном и графическом процессорах (CPU и GPU). Выбор подходящих процессоров и графических карт позволит запустить суперкомпьютерную платформу и значительно ускорить вычисления, связанные с искусственным интеллектом на выделенном или виртуальном (VPS) сервере.

Как выбрать подходящий процессор для вашего ИИ-сервера?

Процессор — это основной «вычислитель», который получает команды от пользователя и выполняет «циклы команд», которые дадут желаемые результаты. Поэтому большая часть того, что делает сервер ИИ таким мощным, — это процессор, который находится в его сердце.

Возможно, вы ожидаете увидеть сравнение процессоров AMD и Intel. Да, эти два лидера в отрасли стоят на переднем крае производства процессоров, а линейка процессоров Intel пятого поколения Intel® Xeon® (кстати, уже анонсировано шестое поколение) и линейка AMD EPYC™ 8004/9004 представляют собой вершину развития CISC-процессоров на базе x86.

Если вы ищете отличную производительность в сочетании со зрелой и проверенной экосистемой, то выбор топовых продуктов от этих производителей будет правильным решением. Если бюджет ограничен, можно рассмотреть более старые версии процессоров Intel® Xeon® и AMD EPYC™.

Даже настольные процессоры от AMD или Nvidia старших моделей будут хорошим выбором для начала работы с ИИ, если ваша рабочая нагрузка не требует большого количества ядер и ограниченных возможностей многопоточности. На практике для языковых моделей выбор между типами CPU будет иметь меньшее значение, чем выбор между графическим ускорителем или объемом установленной в сервере оперативной памяти.

Хотя некоторые модели (например 8x7B от Mixtral) могут на процессоре показать результаты, сравнимые с вычислительными мощностями тензорных ядер видеокарт, но и потребовать вдвое–втрое больший объем ОЗУ, чем в связке CPU + GPU. Например модель, которая будет работать на 16 GB ОЗУ и 24 Гб GPU видеопамяти, при работе только на центральном процессоре может потребовать до 64 Гб оперативной памяти.

Помимо AMD и Intel существуют и другие варианты. Это могут быть решения от на основе архитектуры ARM, например NVIDIA Grace™, который сочетает ядра ARM с запатентованными функциями NVIDIA или Ampere Altra™.

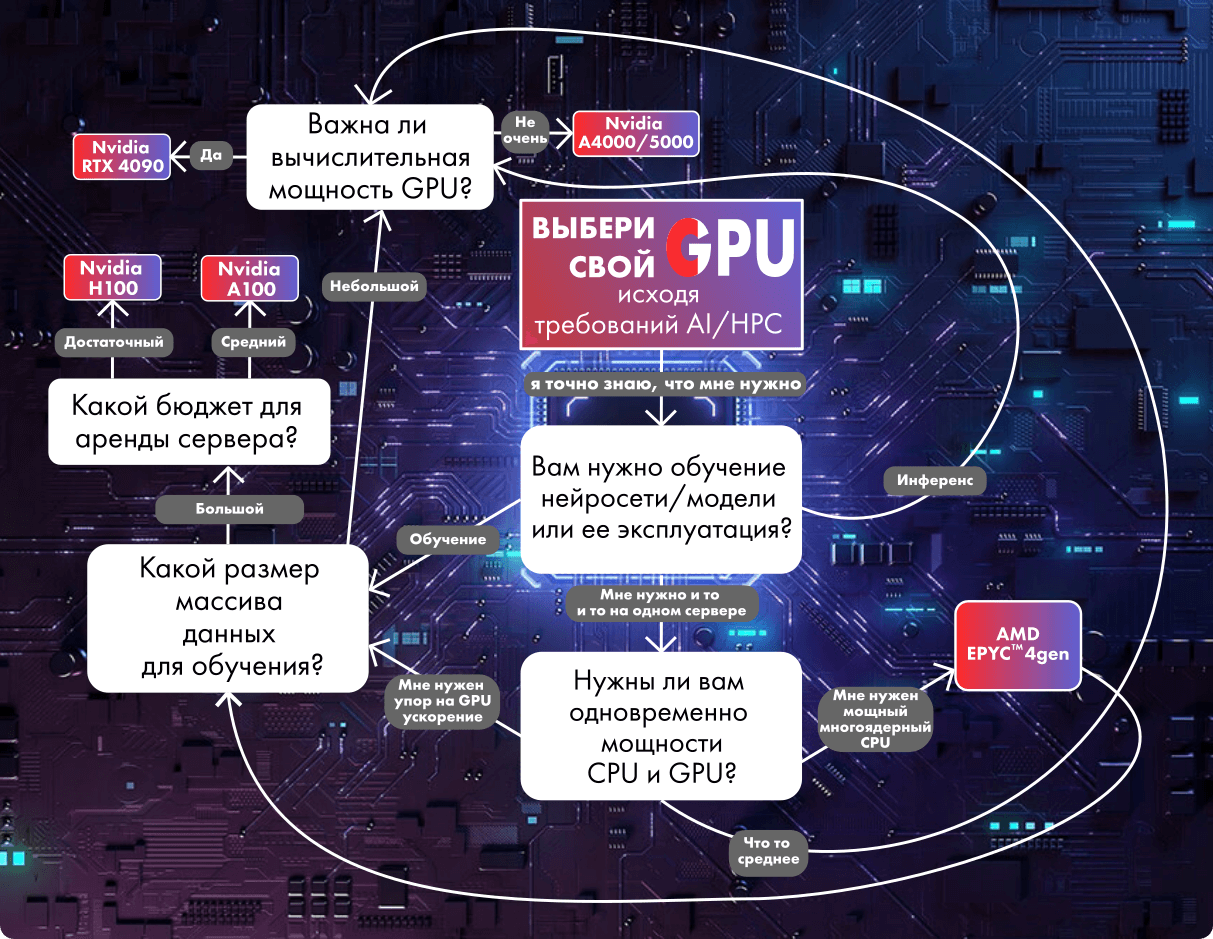

Как выбрать подходящий графический процессор (GPU) для вашего ИИ-сервера?

Графический процессор (GPU) играет важную роль в работе ИИ-сервера. Он служит ускорителем, который помогает центральному процессору (CPU) обрабатывать запросы к нейросетям гораздо быстрее и эффективнее. GPU может разбивать задачу на более мелкие сегменты и обрабатывать их одновременно с помощью параллельных вычислений или специализированных ядер. Те же тензорные ядра NVIDIA обеспечивают на порядок более высокую производительность при вычислениях в формате 8 бит с плавающей точкой (FP8) в Transformer Engine, Tensor Float 32 (TF32) и FP16 и отлично себя показывают в высокопроизводительных вычислениях (HPC).

Особенно это заметно не при инференсе (работе нейросети), а при ее обучении, так как, например, для моделей с FP32 этот процесс может занять несколько недель или даже месяцев.

Чтобы сузить круг поиска, нужно найти ответ на следующие вопросы:

-

Изменится ли характер моей рабочей нагрузки ИИ со временем?

Большинство современных графических процессоров предназначены для выполнения очень специфических задач. Архитектура их чипов может подходить для определенных областей разработки или применения ИИ, а новые аппаратные и программные решения могут сделать предыдущее поколение GPU неконкурентоспособным уже в ближайшие два–три года.

-

Будете ли вы в основном заниматься обучением ИИ или инференсом (эксплуатацией)?

Эти два процесса лежат в основе всех современных итераций ИИ с ограниченным бюджетом по памяти.

Во время обучения модель ИИ поглощает большое количество больших данных с миллиардами или даже триллионами параметров. Она корректирует «веса» своих алгоритмов до тех пор, пока не сможет последовательно генерировать правильный результат.

Во время инференса ИИ опирается на «память» своего обучения, чтобы реагировать на новые входные данные в реальном мире. Оба этих процесса требуют значительных вычислительных ресурсов, поэтому для ускорения работы устанавливаются карты и модули расширения GPU.

Для обучения искусственного интеллекта предназначены графические процессоры, оснащенные специализированными ядрами и механизмами, которые могут оптимизировать этот процесс.

Например, NVIDIA H100 с 8 ядрами GPU способна обеспечить более 32 петафлопс производительности при глубоком обучении в FP8. Каждый H100 содержит тензорные ядра четвертого поколения, использующие новый тип данных FP8, а также Transformer Engine для оптимизации обучения модели. Недавно NVIDIA представила следующее поколение своих GPU B200, которые будут еще мощнее.

Хорошей альтернативой решениям AMD будет AMD Instinct™ MI300X. Его особенностью является огромная память и высокая пропускная способность данных, что важно для инференс-режима генеративных ИИ, например больших языковых моделей (LLM). AMD утверждает, что их GPU на 30% эффективнее, чем решения от NVIDIA, хотя и проигрывают по программному обеспечению.

Если вы готовы немного пожертвовать производительностью, чтобы уложиться в бюджетные ограничения, или если набор данных, с которым вы обучаете ИИ, не такой большой, стоит присмотреться к другим предложениям от AMD и NVIDIA. Для инференс-режимов или когда нет необходимости в бесперебойной работе под полной загрузкой в режиме 24/7, для обучения подойдут «бытовые» решения на основе Nvidia RTX 4090 или даже RTX 3090.

Если вы ищете стабильность в долговременных вычислениях для обучения моделей, можно рассмотреть видеокарты Nvidia RTX A4000 или A5000. Хотя H100 на шине PCIe может быть более мощным решением (на 60–80% в зависимости от задач), RTX A5000 доступнее и подойдет для некоторых задач (например, для работы с моделями 8x7B).

Из более экзотических решений для инференса можно обратить внимание на карты AMD Alveo™ V70, NVIDIA A2/L4 Tensor Core, Qualcomm® Cloud AI 100. В ближайшее время AMD и NVIDIA на рынке обучения ИИ готовятся потеснить Intel с GPU Gaudi 3.

Исходя из вышеперечисленного и с учетом оптимизации программного обеспечения для HPC и AI, можем порекомендовать сервера с процессорами Intel Xeon и AMD Epyc и GPU от NVIDIA. Для инференса ИИ можно использовать GPU от RTX A4000/A5000 до RTX 3090, а для обучения и работы мультимодальных нейросетей стоит заложить бюджет на решения от RTX 4090 до H100.