Медиакомбайн с веб-интерфейсом для работы с LLM-моделями Open WebUI за последний месяц серьезно обновился дважды (сначала до версии 0.3.35, а затем — до стабильной версии 0.4.5), которые привнесли множество полезных изменений. Поскольку мы используем его в нашем AI-чат-боте, то хотим рассказать, какие новшества и улучшения они привнесли и на что стоит обратить внимание при обновлении.

Начнем с процесса обновления: рекомендуем сразу обновлять и Ollama, и OpenWebui. Можете воспользоваться нашей инструкцией для Docker-установки или запустить команду

pip install --upgrade open-webuiесли вы установили OpenWebUI через PIP. В Windows Ollama у вас попросит обновиться сама.

Попробуйте AI-чат-бот на собственном GPU-сервере.

HOSTKEY предлагает персональный AI-чат-бот на основе Ollama и OpenWebUI с предустановленной моделью Llama3.1 8b, который доступен на вашем собственном сервере! Это инновационное решение разработано для тех, кто ценит безопасность данных, масштабируемость и экономию средств.

Основные преимущества

- Безопасность и конфиденциальность данных. Все данные обрабатываются на вашем сервере, что исключает доступ третьих лиц к конфиденциальным данным.

- Экономия средств. Оплачивайте только аренду сервера — использование нейросети бесплатно, стоимость не зависит от количества пользователей.

- Масштабируемость. Легко переносите чат-бот между серверами, увеличивайте или уменьшайте вычислительные мощности и контролируйте расходы.

- Гибкая настройка. Подключайте и настраивайте различные LLM-модели, в том числе Phi3, Mistral, Gemma и Code Llama.

0.3.35

Сперва расскажем о полезных изменениях в версии Open WebUI 0.3.35:

-

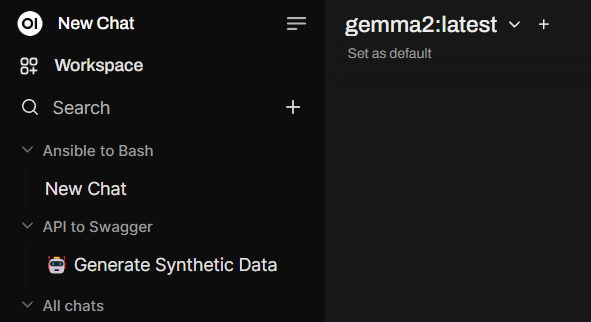

Поддержка папок для чатов. Если раньше чаты шли сплошным списком, теперь можно организовать все по папкам и возвращаться к необходимым вам диалогам или удачным промтам.

-

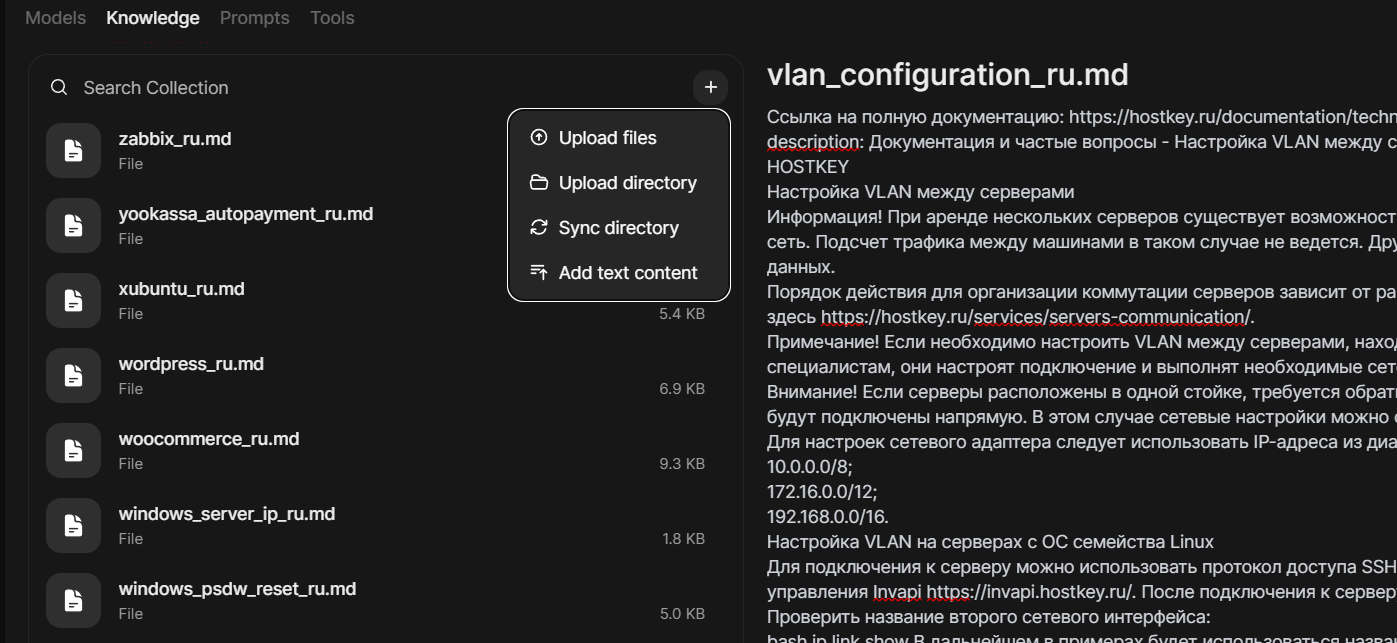

Улучшенная коллекция знаний. Это одно из ключевых новшеств, которое делает работу с формированием базы знаний для запросов Retrieval-Augmented Generations (RAG) гораздо проще. Теперь вы формируете коллекцию, а уже в ней добавляете необходимые документы. И надо сказать, последние стало гораздо удобнее просматривать и добавлять. Стало возможным добавлять документы целыми директориям и синхронизировать изменения между локальной директорией с файлами и файлами в базе знаний (ранее для этого приходилось удалять файлы и загружать их заново). А еще появилась возможность добавлять текст в базу знаний через встроенный редактор.

-

Расширенная система тегов. Теги теперь занимают меньше места! Используйте новую систему поиска по тегам tag для управления, поиска и упорядочивания ваших бесед более эффективно без загромождения интерфейса.

-

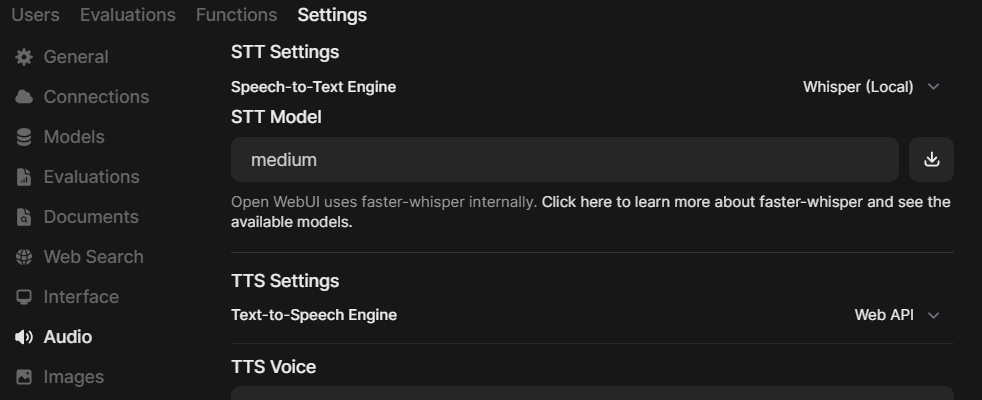

Удобная настройка модели Whisper. Теперь можно задать, какую модель необходимо использовать для перевода речи в текст. Ранее по умолчанию была только base, что вызывало проблемы с тем же русским языком, для которого оптимальна модель medium.

Из других новшеств:

- экспериментальная поддержка S3;

- отключение уведомлений об обновлениях, если такие сообщения вам мешали;

- процент релевантности цитаты в RAG;

- копирование Mermaid-диаграмм;

- поддержка RTF-форматирования.

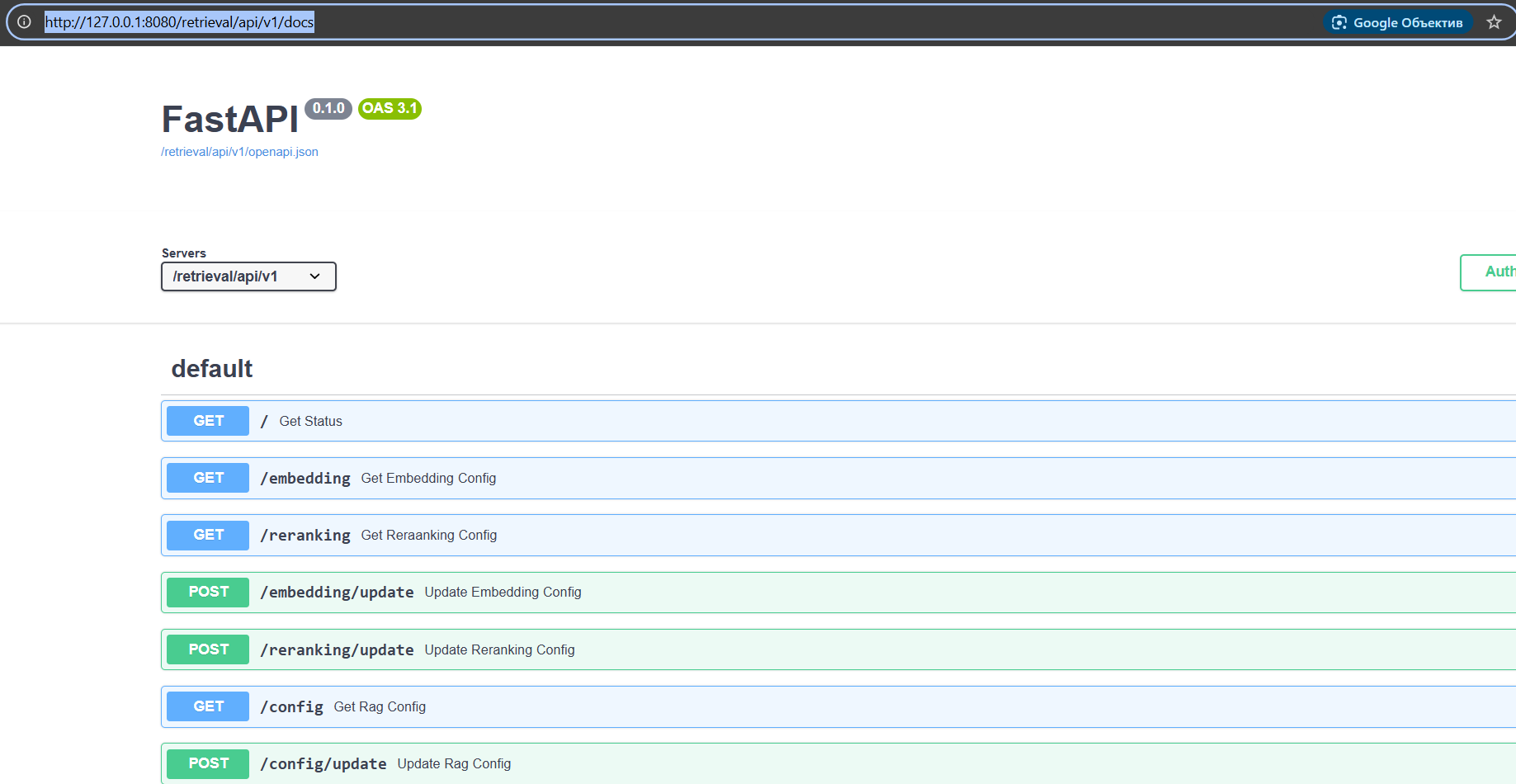

Также появилась долгожданная API-документация, и теперь, например, достаточно просто использовать кастомные модели с RAG из Open WebUI из внешних приложений. Документация в swagger, доступ к ней можно получить через эндпоинты.

Подробнее об API можно прочитать в документации Open WebUI.

0.4.5

Следующие большие изменения произошли с выходом версии 0.4.x. Увы уже привычно, что сразу после выхода версии 0.4.0 разработчики сломали кучу работающего ранее функционала, а запланированные новшества наоборот забыли включить. Поэтому стоило подождать и по прошествии нескольких релизов (на момент написания статьи Open WebUI имел версию 0.4.5) смело обновляться. Что же нового появилось в этой версии?

Первое, что бросается в глаза, — это скорость работы. По ощущениям запросы обрабатываются и выводятся раза вдвое–втрое быстрее, поскольку в Open WebUI внедрены оптимизации кэширования для более быстрого загрузки моделей.

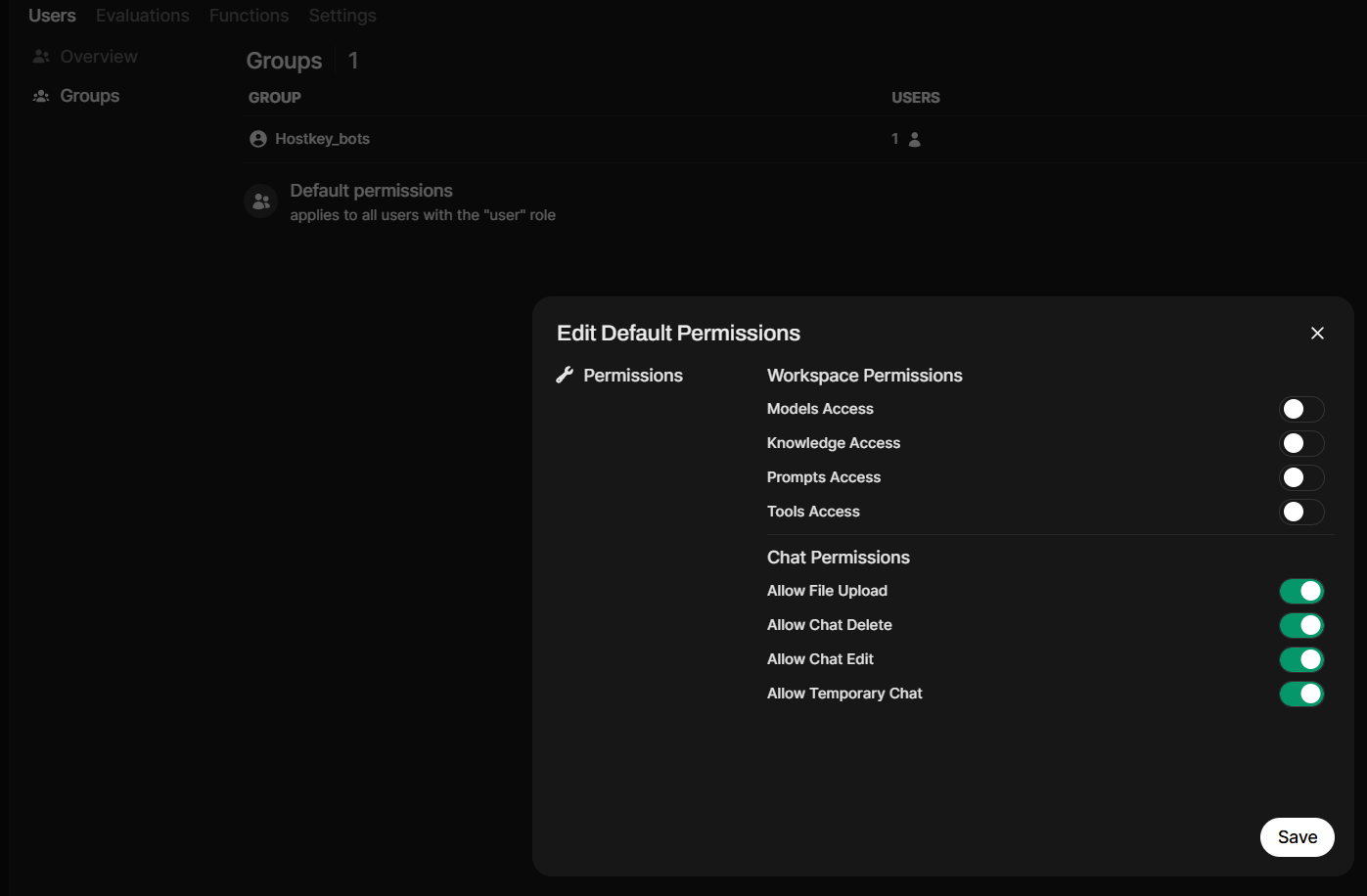

Второе новшество коснулось управления пользователями. Теперь можно создавать и управлять группами пользователей, что упрощает их организацию, четко разграничивать доступ к моделям и базам знаний, а также выдавать разрешения не индивидуально каждому пользователю, а по группам. Все это упрощает использование Open WebUI в организациях.

Появилась и аутентификация через LDAP, и поддержка ключей API Ollama, что позволяет управлять учетными данными Ollama при их размещении за прокси-серверами, в том числе использовать ID-префиксы для правильного различения нескольких экземпляров Ollama.

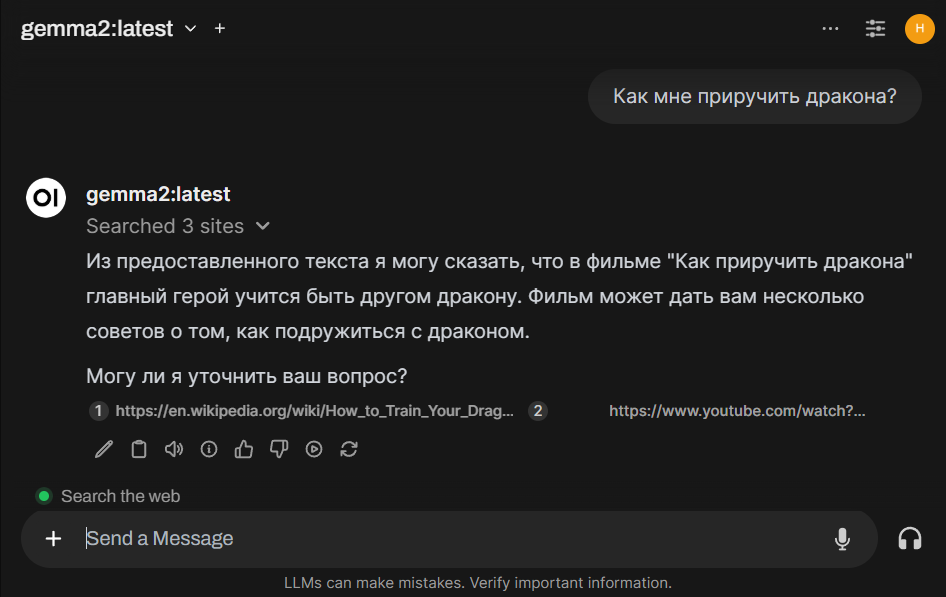

Также стоит отметить появление индикатора, который показывает включен ли у вас веб-поиск или другие инструменты.

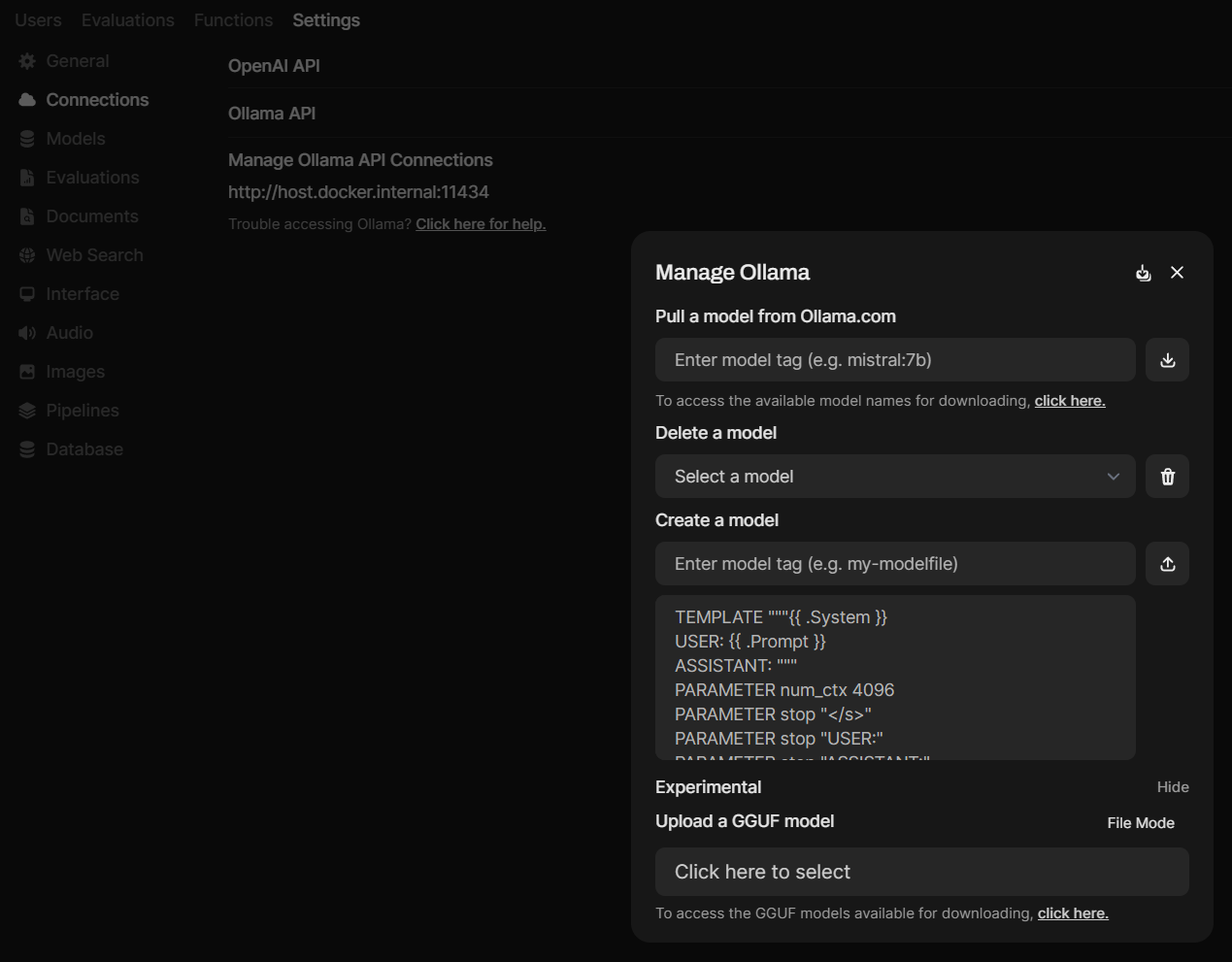

Опции по управлению моделями в Ollama теперь сгруппированы в одном месте.

Из других новшеств:

- Изменения в интерфейсе: переработанная рабочая зона моделей, промтов, запросов.

- Возможность быстрого включения или выключения опции аутентификации по API-ключу.

- Улучшение точности RAG за счет интеллектуальной предварительной обработки истории чата для определения наилучших запросов перед извлечением.

- Возможность опционально преобразовывать вставленный большой текст в загружаемый файл, что сохраняет интерфейс чата более чистым.

- Исправление проблем с интеграцией поиска DuckDuckGo с повышением стабильности и производительность поиска при работе в пределах лимитов скорости.

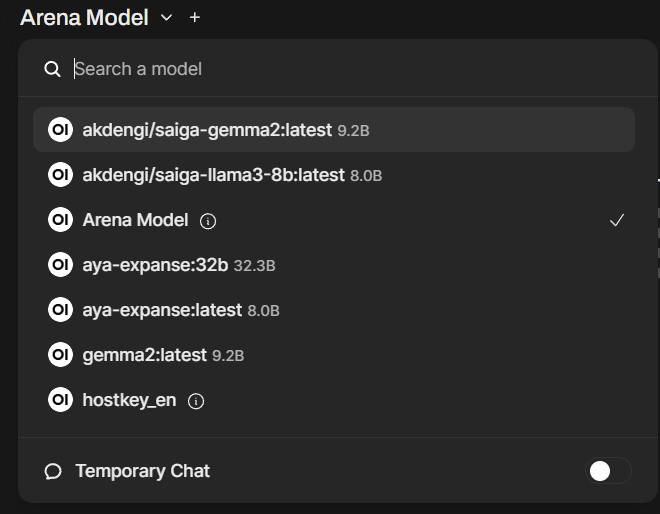

- Новый режим моделей Arena Model. Запрос из чата отправляется на случайную подключенную к Open WebUI модель, что позволяет выполнить их A/B-тестирование и выбрать лучшую.

Отдельно стоит отметить процесс первоначальной настройки, где пользователя четко информирует о том, что он создает учетную запись администратора. Раньше пользователи сразу попадали на страницу входа без этого разъяснения и часто забывали пароль админа.

Что стоит учесть при обновлении до версии 0.4.5? Изменился алгоритм работы с выбиранием модели: исчезла возможность указать модель «по дефолту» для пользователя, и теперь модель, с которой вы работаете в текущий момент, будет сохраняться при создании нового чата.

Это только часть новшеств, улучшения коснулись также инструментов и функций и администрирования — об этом можно почитать в Release Notes к каждому выпуску Open Webui. А вы используете Open Web UI у себя дома или на работе?

P. S. При обновлении Ollama до версии v0.4.4 (она почти сравнялась по версионности с Open WebUI) вам среди прочего станут доступны такие новые модели, как:

- Marco-o1 — модель рационального мышления от Alibaba.

- Llama3.2-vision — мультимодальная модель, понимающая изображения.

- Aya-expanse — модель общего плана, которая официально поддерживает 23 языка.

- Qwen2.5-coder — одна из лучших моделей для написания программного кода.

Попробуйте AI-чат-бот на собственном GPU-сервере.

HOSTKEY предлагает персональный AI-чат-бот на основе Ollama и OpenWebUI с предустановленной моделью Llama3.1 8b, который доступен на вашем собственном сервере! Это инновационное решение разработано для тех, кто ценит безопасность данных, масштабируемость и экономию средств.

Основные преимущества

- Безопасность и конфиденциальность данных. Все данные обрабатываются на вашем сервере, что исключает доступ третьих лиц к конфиденциальным данным.

- Экономия средств. Оплачивайте только аренду сервера — использование нейросети бесплатно, стоимость не зависит от количества пользователей.

- Масштабируемость. Легко переносите чат-бот между серверами, увеличивайте или уменьшайте вычислительные мощности и контролируйте расходы.

- Гибкая настройка. Подключайте и настраивайте различные LLM-модели, в том числе Phi3, Mistral, Gemma и Code Llama.