Используя сайт, вы соглашаетесь на размещение файлов cookie и сбор системных данных. Подробнее.

Персональный чат-бот на основе Ollama, LLM с открытым исходным кодом Llama3 и OpenWebUI-интерфейс на вашем собственном сервере.

Персональный чат-бот на основе Ollama, LLM с открытым исходным кодом Llama3 и OpenWebUI-интерфейс на вашем собственном сервере.

Арендуйте виртуальный или выделенный сервер HOSTKEY с предустановленным и готовым к работе чат-ботом, который может обрабатывать ваши данные и документы, используя различные LLM-модели.

Вы можете подключить последние версии моделей Phi3, Mistral, Gemma, Code Llama.

Серверы доступны в Нидерландах, России, Финляндии, Исландии и Германии.

“AI-чат-бот на своем сервере” по умолчанию имеет предустановленную модель:

Вы можете устанавливать и удалять любые модели из библиотеки Ollama. Вы также можете запускать несколько моделей одновременно, если выбранный вами сервер способен справиться с нагрузкой.

AI-чат-бот, работающий на вашем собственном сервере, обеспечивает высочайшие стандарты безопасности. Все данные хранятся и обрабатываются исключительно на вашем сервере.

OpenWebUI позволяет использовать несколько моделей в одном рабочем окне — это ускоряет работу и позволяет обработать один промт в нескольких моделях одновременно без переключения окон и лишних затрат. Просто сделайте один запрос и сравните результаты, выбрав лучший.

AI-чат-бот на собственном сервере позволяет проводить код-ревью без риска утечки кода, который защищен политиками компании о конфиденциальной информации и коммерческой тайне. Также в подобных задачах требуется масштабируемость решения — возможность увеличения серверных мощностей в процессе работы.

Подключите AI-чат-бот к вашей базе знаний и используйте его для генерации ответов на частые вопросы пользователей или сотрудников.

Вы можете анализировать корпоративные документы, проводя все процессы на вашем сервере и не отправляя конфиденциальные файлы во внешнюю среду.

Собственный чат-бот на основе Ollama, LLM Llama3 и OpenWebUI — решение HOSTKEY, созданное на базе официально бесплатного ПО с открытым исходным кодом.

Ollama — это проект с открытым исходным кодом, который служит мощной и удобной платформой для запуска LLM на локальном компьютере. Ollama доступен по лицензии MIT License.

Qwen3 - семейство моделей Qwen3 распространяется согласно свободной лицензии Apache 2.0. Это делает его веса открыто доступными для широкой публики и разнообразных вариантов использования.

Open WebUI — это расширяемый, многофункциональный и удобный веб-интерфейс, предназначенный для работы в автономном режиме и доступный по лицензии MIT License.

Мы гарантируем, что на сервере установлено безопасное оригинальное программное обеспечение.

Чтобы установить AI-чат-бот, нужно выбрать лицензию AI Chatbot в разделе «AI и машинное обучение» во время заказа сервера на сайте HOSTKEY. Наша система автоматического деплоя произведет установку программного обеспечения на ваш сервер.

В тарифе “AI-чат-бот на своем сервере” по умолчанию доступна модель: qwen3:14b. Вы можете устанавливать и удалять любые модели, доступные в библиотеке Ollama.

Собственный чат-бот на основе Ollama, LLM с открытым исходным кодом Llama3 и OpenWebUI имеет ряд преимуществ, по сравнению с популярными платными сервисами, предлагающими свои услуги по подписке.

Современные компании и частные пользователи всё чаще стремятся к автономности в вопросах работы с ИИ. Размещение персонального AI-чата на собственном сервере — это уже не экзотика, а реальная альтернатива облачным решениям. В этой статье мы подробно рассмотрим, как развернуть мощного чат-бота на базе Ollama, модели Llama3 с открытым исходным кодом и удобного интерфейса OpenWebUI. Также проанализируем практическое значение такого подхода, его плюсы для бизнеса и частного использования.

Ollama — это лёгкая и гибкая среда для работы с языковыми моделями, которая позволяет запускать крупные LLM локально или на сервере. Её ключевая задача — простое управление моделями: загрузка, запуск, обновление, удаление. Всё это осуществляется через понятный CLI или REST API, что удобно для разработчиков и DevOps-инженеров.

Llama3 — мощная языковая модель с открытым исходным кодом от Meta. Она способна генерировать связный и логичный текст, поддерживает инструкции, диалоговые сессии, кодогенерацию и более. За счёт своей производительности и доступности модель является оптимальной альтернативой GPT-4 в приватных развертываниях.

Для удобства взаимодействия с ботом используется OpenWebUI — веб-интерфейс, аналогичный ChatGPT, но полностью автономный. Он поддерживает несколько пользователей, историю сообщений, markdown-разметку, поддержку изображений и другие удобные функции, делая общение с ИИ интуитивно понятным и удобным.

Все данные остаются на вашем сервере. Вы не передаёте конфиденциальную информацию в облачные сервисы, что особенно важно в медицинской, юридической, финансовой и корпоративной сферах. Также вы контролируете логи, доступы, политики шифрования и резервного копирования.

Собственный сервер предоставляет возможности кастомизации, недоступные в SaaS-продуктах: доработка логики, интеграция в существующую IT-инфраструктуру, подключение внешних баз знаний, создание специализированных агентов.

Заплатив за железо и потратив немного времени на настройку, вы получаете мощного AI-помощника без абонентской платы, ограничений по токенам или количеству запросов.

Бот может стать помощником в документообороте, отвечать на часто задаваемые вопросы, формировать отчёты, структурировать внутреннюю документацию.

Юристы, врачи, инженеры, преподаватели могут использовать такую систему в качестве ассистента, обученного на собственных материалах — от законодательных баз до научных статей.

Размещение чат-бота на собственном сервере позволяет бизнесу развёртывать техподдержку без рисков утечки пользовательских данных.

Сценарии с Python-скриптами, взаимодействие через API, генерация шаблонных ответов — всё это может быть автоматизировано через локальный чат-бот.

HOSTKEY предлагает арендовать сервер с предустановленным AI Chat Bot на базе Ollama, Llama3 и OpenWebUI. Это готовое решение с оптимальными настройками:

Дополнительно можно подключить:

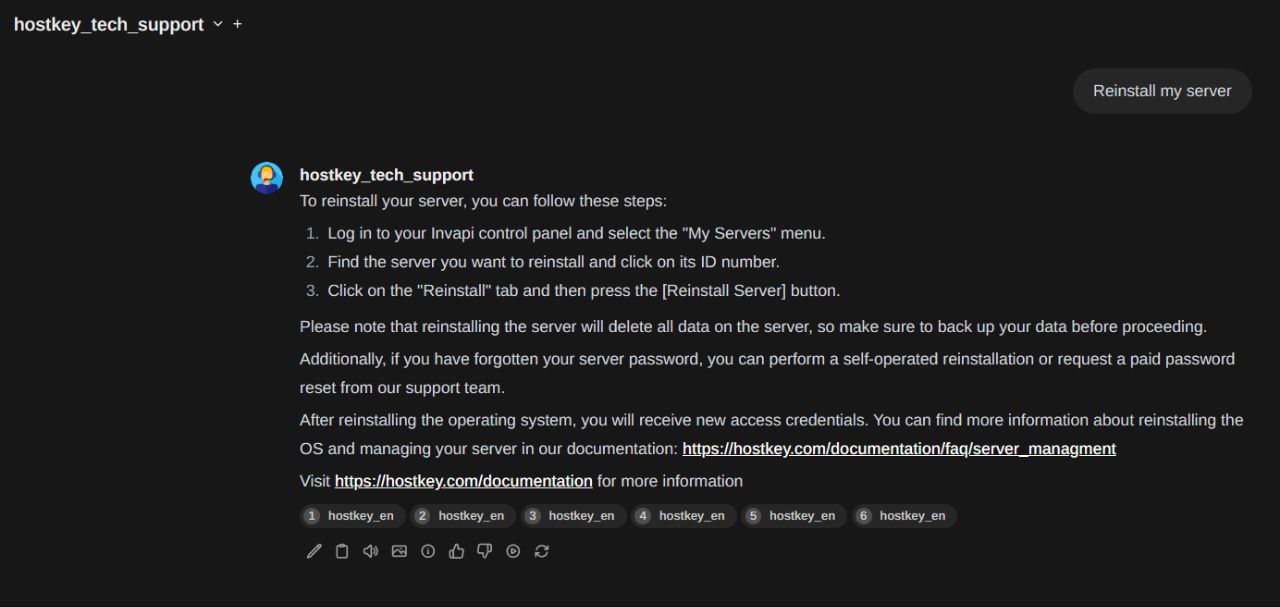

HOSTKEY предоставляет техническую поддержку и консультации по настройке. Также возможна установка обновлений модели, подключение альтернативных моделей (например, Mistral, Phi, Gemma) и настройка дополнительных пользовательских сценариев.

Одним из ключевых факторов, побуждающих компании переходить к локальным решениям на базе моделей с открытым кодом, является прозрачность и контроль над лицензированием. Большинство облачных ИИ-платформ работают на коммерческой основе, где пользователь не владеет ни моделью, ни инфраструктурой, ни даже своими данными в полной мере. Применение Llama3 в рамках Ollama позволяет:

Такой подход снижает юридические риски, особенно для организаций в сферах с высокими требованиями к соблюдению регуляторных стандартов — страхование, медицина, финансы, госслужба.

AI-чат на сервере — это не просто копия облачного ассистента. Это гибкая архитектура, позволяющая проводить:

На выходе получается не абстрактный бот, а полноценный корпоративный ассистент, владеющий контекстом и способный быстро ориентироваться в специфике бизнеса.

Запуск чат-бота внутри компании — это не обязательно изоляция. Система легко интегрируется с уже работающими сервисами:

Таким образом, бот может выступать связующим звеном между отделами, ускоряя взаимодействие и снижая нагрузку на специалистов.

Размещение LLM-бота на собственном сервере открывает широкие возможности для малых команд и стартапов:

Хотя базовая модель Llama3 является текстовой, в локальной системе можно развернуть мультимодальный стек:

Такой AI становится по-настоящему универсальным — готовым к использованию в разных форматах.

Сравним два подхода: облачное API и локальный сервер.

| Параметр | Облачное API (GPT-4) | Собственный сервер с Llama3 |

| Стоимость 1 млн токенов | ~$30 | 0 (после развертывания) |

| Приватность | Частично | Полная |

| Обновления и контроль | Ограниченный | Полный |

| Возможность кастомизации | Минимальная | Без ограничений |

| Зависимость от третьих лиц | Высокая | Отсутствует |

| Первоначальные затраты | 0 | От $40–50/мес за сервер |

При активном использовании бот на сервере окупается за 1–2 месяца, особенно в командах с высокой нагрузкой (500 000+ токенов в день).

Мир движется в сторону суверенных ИИ-систем. Крупные корпорации, государственные учреждения, стартапы и энтузиасты уже массово переходят к локальным LLM, обученным на своих данных, с полной изоляцией от внешних платформ.

В ближайшие 2–3 года можно ожидать:

Развёртывание персонального AI Chat Bot на собственном сервере с помощью Ollama, Llama3 и OpenWebUI — это шаг к полной цифровой независимости. Вы получаете надёжный инструмент, который работает в ваших интересах, сохраняет приватность, адаптируется под бизнес и не требует постоянных вложений. HOSTKEY предоставляет оптимальное коммерческое решение: инфраструктура, поддержка и готовый к работе ИИ-инструмент — всё в одном месте.

Если вы хотите получить ИИ-помощника без компромиссов — персональный сервер с AI Chat Bot от HOSTKEY станет идеальной отправной точкой.